الذكاء الاصطناعي دون إنترنت: كيف يمكنك تشغيله محليًا على جهازك؟

جميعنا الآن نستخدم أدوات الذكاء الاصطناعي لأسبابٍ مختلفة، لكننا نستخدمها على السحابة، أي أننا نحتاج اتصالًا بالإنترنت لكي تعمل، سواء كنا نستخدمها من خلال تطبيق مخصص أو من خلال واجهة الخدمة على المتصفح، ولكن، هل تعلم أنك تستطيع تشغيل نماذج ذكاء اصطناعي شهيرة مثل DeepSeek محليًا على جهازك دون اتصالٍ بالإنترنت؟

الأمرُ ليس جديدًا، ومنصة Ollama تقدمه منذ أشهر وربما أكثر، لكن الخدمة كانت تُقدم في واجهة سطر الأوامر أو "الطرفية Terminal"، أما الآن فقد أصبحت تُقدم في واجهة مُستخدم على غرار أي برنامجٍ عاديّ، تابع قراءة السطور التالية وستفهم كل شيء، لكن أولًا يجب أن تتعرف على فوائد تشغيل الذكاء الاصطناعي محليًا.

ما فوائد تشغيل الذكاء الاصطناعي محليًا؟

هناك مميزات عديدة لهذا الأمر، أهمها حماية الخصوصية، حيث تتم معالجة بياناتك على حاسوبك الخاص، بعيدًا عن الخوادم أو السيرفرات التابعة للشركات، بالتالي لن تُسرَّب محادثاتك كما حدث مؤخرًا مع ملايين محادثات ChatGPT!

الميزة الثانية، هي أنك لن تحتاج اتصالًا بالإنترنت كي تستفيد من نماذج الذكاء الاصطناعي؛ التي ستستطيع أن تصل إليها وتستخدمها في أي وقت ومكان عبر اللابتوب الخاص بك دون إنترنت.

أما الميزة الثالثة، والمهمة جدًا أيضًا، أن تجربة الاستخدام نفسها ستكون أفضل، إذ ستأتيك الردود سريعًا، لأنها لن تكون مقيدة بضغط وتكدس السيرفرات.

متطلبات تشغيل الذكاء الاصطناعي محليًّا

لتشغيل نماذج الذكاء الاصطناعي محليًا، يجب أن تتوفر عدة متطلبات في حاسوبك، منها:

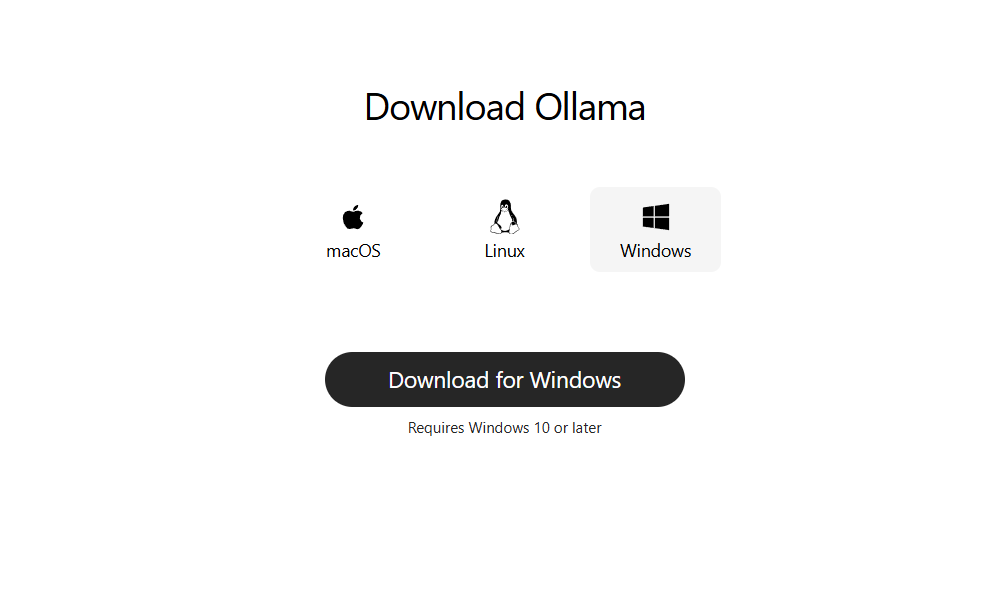

1. أن يكون نظام التشغيل حديثًا، فعلى الويندوز، يجب أن تستخدم ويندوز 10 أو ويندوز 11، وعلى الماك يُفضل أن تستخدم macOS 12 فما فوق، أما على لينكس فبداية من Ubuntu 18.04 فما فوق، فمن المهم أن تستخدم هذه الأنظمة الحديثة لأن نماذج Ollama صُممت لتعمل عليها.

2. بالنسبة لمساحة التشغيل، يجب ألا تقل عن 12 جيجابايت لتثبيت النموذج الأساسي، ومع كل نموذجٍ جديد، ستحتاج مساحةً إضافية، وعمومًا، يُفضل ألا تقل المساحة المخصصة على حاسوبك عن 50 جيجابايت.

3. المعالج كذلك يجب أن يكون بـ 4 أنوية على الأقل لتشغيل المهام الأساسية، ويُفضل أن يكون بـ8 أنوية، وببساطة، معالج من الجيل الحادي عشر من إنتل أو بمعمارية Zen 4 من AMD سيكون خيارًا جيدًا، لأن هذه المعالجات تدعم تعليمات متقدمة مثل AVX512، التي تُحسن من كفاءة معالجة الذكاء الاصطناعي.

4. الرامات أيضًا يُفترض ألا تقل عن 8 جيجابايت لتشغيل النماذج الأساسية، ويُفضل أن يكون هذا الرقم 16 جيجابايت.

5. أما كارت الشاشة، فهو ليس متطلبًا أساسيًا هنا، لكن إذا كنت تمتلك واحدًا، ستكون العملية أفضل وأكثر سلاسة، وكلما كانت ذاكرة الكارت VRAM أكبر، كان الأداء أفضل وأفضل.

أخيرًا وليس آخرًا، ستحتاج إلى اتصال بالإنترنت من أجل تحميل الأداة والنماذج فقط لأول مرة، بعد ذلك ستستطيع تشغيلها محليًا دون اتصال، وبعد أن هيأنا كل شيء، دعونا ندخل في التفاصيل العملية.

اقرأ أيضًا: ميزة جديدة من ChatGPT.. هل تنجح OpenAI في تقليل إدمان الذكاء الاصطناعي؟

تشغيل الذكاء الاصطناعي محليًا

سنستخدم أداة Ollama ونُطبّق الشرح على التطبيق أو البرنامج الخاص بها، ومَن يريد استخدام النماذج على الـ Terminal يستطيع أن يفعل ذلك أيضًا، من خلال تحميل أداة Ollama من GitHub واتباع التعليمات المذكورة، لكن هذا الشرح سيكون موجهًا للجميع، وبالأخص أولئك الذين لا يفضلون التعامل مع سطر الأوامر.

نبدأ رحلتنا بتحميل أداة Ollama من الصفحة الرسمية؛ فقط ادخل إليها واختر نظام التشغيل ثم اضغط على "Download" مباشرةً.

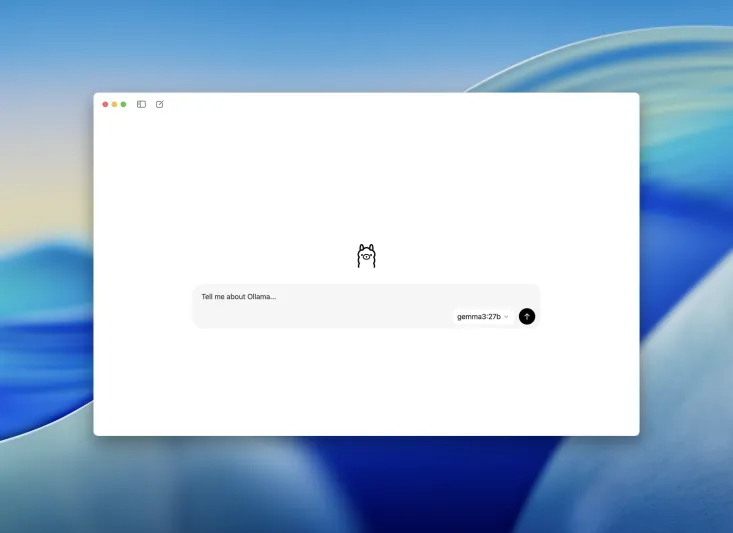

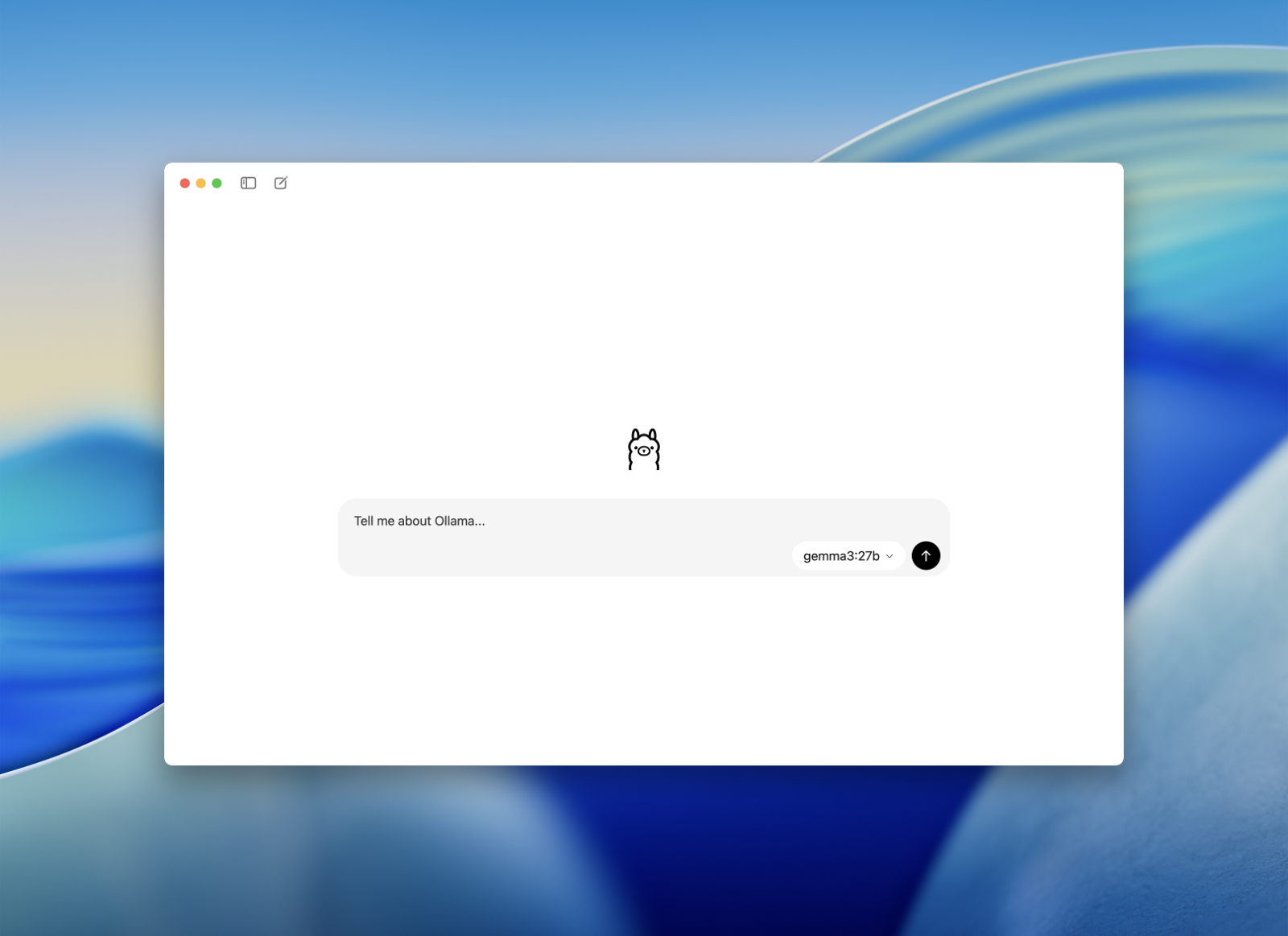

بعد تحميل الأداة وتثبيتها، ستفتح لك واجهةٌ مشابهة لواجهة أداة ChatGPT، على اليسار سترى تفاصيل المحادثات والإعدادات، وبالمنتصف سترى خانة الدردشة وبها جزء لاختيار النموذج المُراد استخدامه من قائمةٍ منسدلة (هناك نموذج افتراضي متاح والبقية تحتاج إلى تحميل)، والأمر بسيط للغاية ويشبه استخدام معظم أدوات ونماذج الذكاء الاصطناعي المشهورة الأخرى.

بالنسبة للإعدادات، يمكنك من خلالها تعديل طول السياق (وأشياء أخرى ربما لن تهمك)، لكن يجب أن تعلم أن هذا الأمر سيكون على حساب موارد الجهاز.

وبالنسبة للاستخدامات فواسعة، مثل إمكانية توليد النصوص وتلخيصها وتحليلها، فضلًا عن المساعدة في فهم الأكواد البرمجية، وتحليل الصور، وغيرها من الاستخدامات.

ومدونة Ollama الخاصة بالتطبيق تقدم شرحًا لأهم المميزات والاستخدامات مدعومًا بالفيديو، يمكنك الاطلاع عليها لتحصل على استفادةٍ أكبر.